GPT-4o

GPT-4o (“o” for “omni”)

Document : Hello GPT-4o | OpenAI

OpenAI에서는 2024.05.13에 텍스트, 오디오, 이미지(영상)을 동시에 입력하였을 때, 출력도 텍스트, 오디오, 이미지를 생성해내는 AGI(Artificial General Intelligent)인 gpt-4o 모델을 발표했다. 모델의 성능은 GPT-4 Turbo 모델과 같은 성능에 non-english에 대한 정확도도 향상되었다. 이번 gpt-4o 모델은 특히, 이미지를 인식하는 비전영역과 음성을 인식하는 오디오영역에서 더 향상된 성능을 보인다. 그와 동시에 더 빠르고, 50% 낮아진 가격으로 API를 사용할 수 있게 되었다. 실제 ChatGPT에서 gpt-4o 모델로 프롬프트를 입력했을 때의 경우에도 답변속도는 gpt-4와 대비하여 체감상으로도 매우 빠르게 느껴진다.

Model Capabilities

최소 232ms, 평균 320ms 라는 1초도 안되는 시간안에 사람의 음성 입력에 대해 반응한다. 인간의 반응 속도와 거의 흡사하다. gpt-4o 이전의 모델에서 Voice Mode를 사용했을 때, Latency는 평균 2.8초 (GPT-3), 평균 5.4초 (GPT-4)가 걸렸다.

기존의 Voice Mode은 STT, GPT-4, TTS 3가지 모델로 구성되었다. 이는 텍스트←→오디오 변환 작업이 들어가므로 observe tone, multiple speakers, or background noises들을 분석하지 못하며, 따라서 웃음소리, 노래, 감정 표현 등의 반응들을 할 수가 없었다. 하지만 gpt-4o는 텍스트, 이미지, 음성에 대한 입출력을 같은 신경망 모델 내에서 멀티모달로 처리하여 이가 가능해졌다.

gpt-4o 모델은 대화 속의 풍자, 개그를 이해하고 상황에 맞는 웃음소리를 낼 수 있다. 대화 중간에 리액션이나 말을 끊고 발화자가 상대방에게로 넘어가는 경우에도 버벅임없이 사람처럼 아주 자연스럽게 대화가 이어지는 것을 볼 수 있다. 특히나 카메라에 비치는 상황을 거의 실시간으로 묘사해주는 기능은 아주 인상적이다. 또한, Voice Mode를 켠 두 폰의 인공지능끼리 대화도 가능하다. 또는 두사람의 목소리를 내서 하모니로 노래를 불러달라는 요청도 가능하다. 실시간 통역기능에 대한 예시도 있다. ( OpenAI GPT-4o real-time translation on Vimeo )

이러한 다양한 예시들은 공식 document에서 확인해볼 수 있다.

Model Evaluation

텍스트 평가 지표 6가지 중에서 MGSM스코어에서 약간 떨어지고, DROP(f1) 스코어에서도 일정수준 떨어지는 부분을 제외하고는 대체로 압도적인 성능을 보이고 있다.

음성인식모델(일반적인 STT모델)에 대해서 에러율을 측정해보았을 때, 이전의 Whisper-v3모델보다 GPT-4o 16-shot 모델이 압도적으로 낮은 에러율을 보이고 있다.

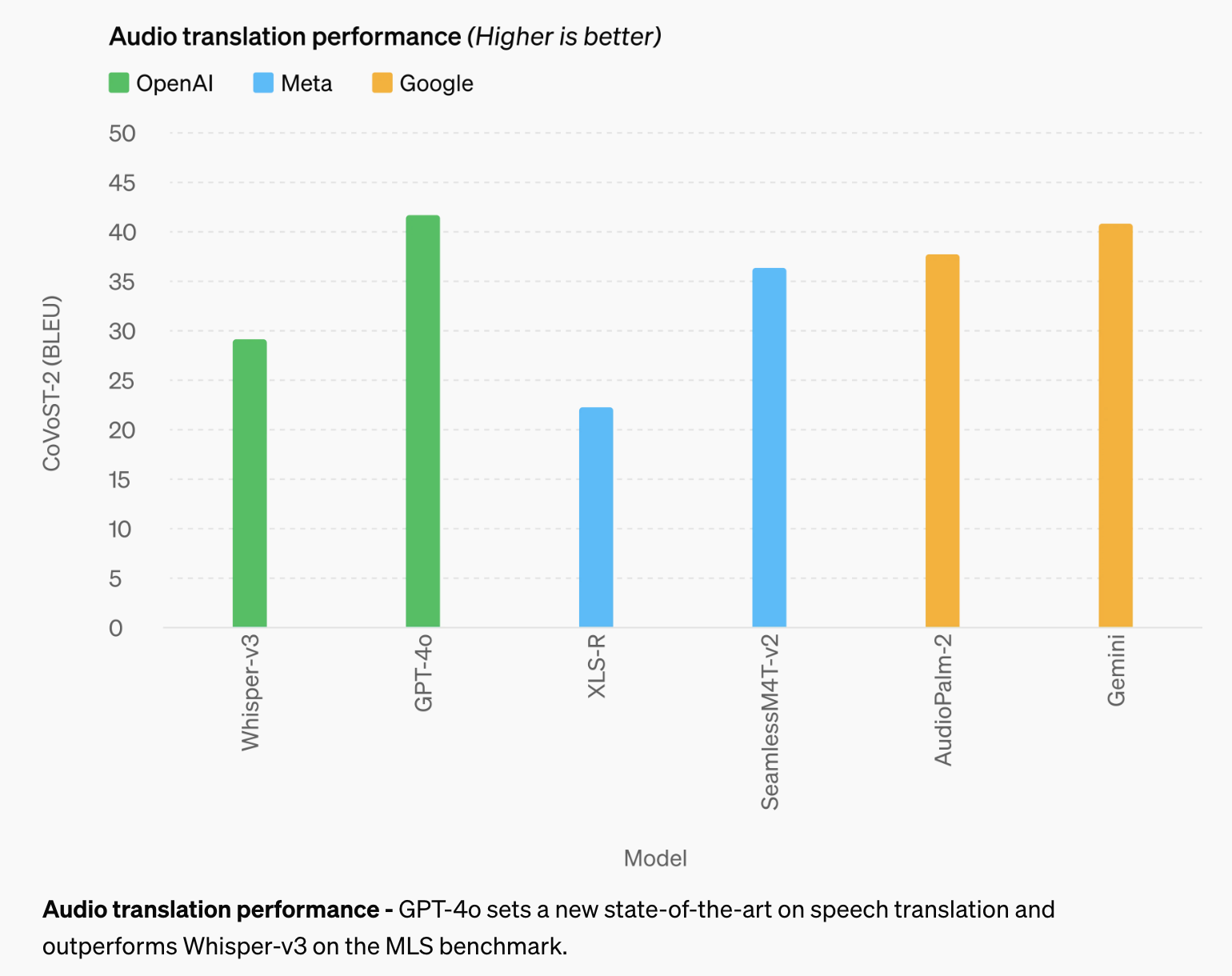

Audio Translation은 입력 음성을 다른 언어로 번역해주는 기능으로 BLEU score기준으로 GPT-4o 모델이 압도적인 성능을 내고있고, Google의 Gemini가 비슷하게 높은 성능을 가진것을 볼 수 있다.

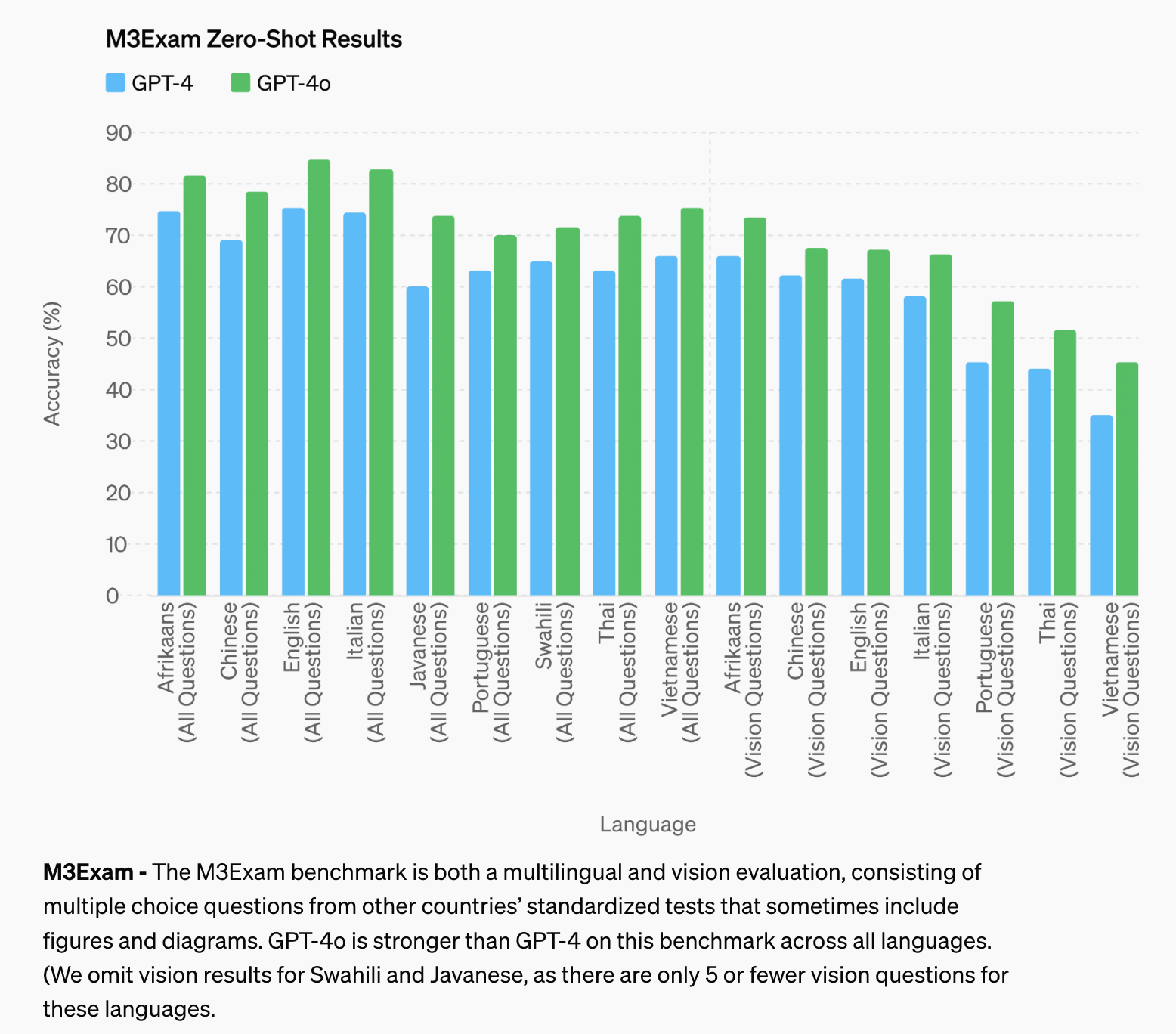

모든 면에서 GPT-4보다 GPT-4o 모델이 월등한 정확도를 내고있다.

M3Exam이 무엇인가?

1. 문제 유형:

- 텍스트 생성: 주어진 프롬프트에 대해 일관성 있고 창의적인 텍스트를 생성하는 능력을 평가합니다.

- 독해 및 이해: 복잡한 텍스트를 이해하고, 그에 대한 질문에 정확하게 답변하는 능력을 측정합니다.

- 지식 테스트: 특정 주제에 대한 모델의 지식 수준을 평가합니다. 예를 들어, 과학, 역사, 문화 등 다양한 분야의 지식을 포함합니다.

- 논리 및 추론: 주어진 정보로부터 논리적 결론을 도출하거나 추론 문제를 해결하는 능력을 평가합니다.

- 코딩 및 기술 문제: 프로그래밍 문제를 해결하고 코드의 정확성 및 효율성을 평가합니다.

2. 데이터 세트:

- 다양한 도메인에서 추출된 방대한 양의 데이터 세트를 사용하여 평가합니다. 여기에는 뉴스 기사, 학술 논문, 대화 데이터, 코드 스니펫 등이 포함됩니다.

모든 테스트에서 가장 높은 성능을 보여주고 있다.

Language Tokenization으로는 20개가 지원된다.

(구자라트어, 텔루구어, 타밀어, 마라티어, 힌디어, 우르두어, 아랍어, 페르시아어, 러시아어, 한국어, 베트남어, 일본어, 중국어, 터키어, 이탈리아어, 독일어, 스페인어, 포르투갈어, 프랑스어, 영어)

아직도 여러 부분에서 제한이 발견되고 있고, 특히 오디오 모델에서 잘못된 답변을 하는 경우가 있으나 gpt-4o 모델 공개 이후에 기술적인 인프라, 사용성을 위한 사후 학습, 다른 모달리티를 공개하기 위해 필요한 안정성 중심으로 연구를 이어 나가고, 더 향상된 모델을 개발할 것이라고 한다.

* 한국어로 참고할만한 사이트 : GPT-4o란 무엇인가? - OpenAI의 새로운 멀티모달 플래그십 모델 - DeepdAive

'AI > Fundamental' 카테고리의 다른 글

| 프롬프트 엔지니어링이란? Prompt Engineering, in-context learning (Zero, One, Few-shot) (0) | 2024.05.07 |

|---|---|

| [NLP] 자연어처리 딥러닝 모델 변천과정 (RNN, LSTM, Seq2Seq, Attention, Transformer) (2) | 2024.04.16 |

| Tensorflow 기초 : 모듈, 레이어, 모델 클래스 구조 알아보기 (1) | 2024.03.27 |

| Transformer 모델 - Positional Encoding 포지셔널 인코딩에 대해서 알아보자. (1) | 2023.12.28 |

| 딥러닝에서 Multi Granularity Feature (다중 세분화 기능) 이란? (0) | 2023.12.15 |