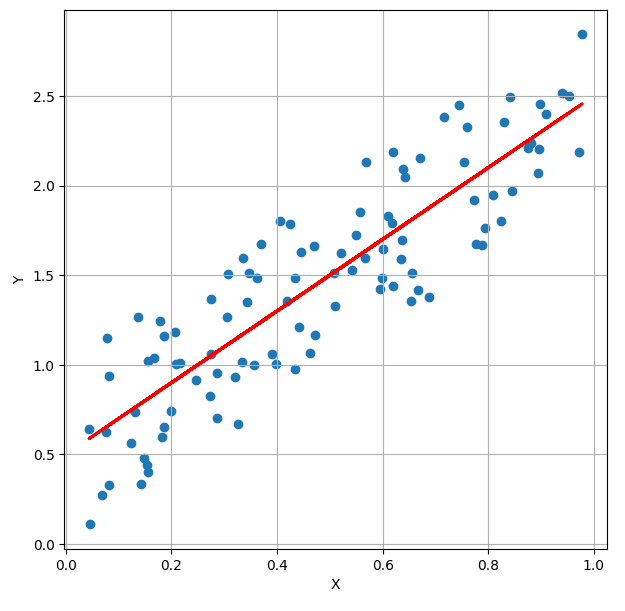

현실의 문제는 해가 정확히 1개가 존재하는, 유일한 해가 있는 방정식으로 풀기 어려운 것이 대부분입니다. 따라서, 우리는 정확히 매칭되는 정답이 아닌, 근사해(approximated solution)를 구해야합니다. 근사해를 구하기 위해 우리는 최소자승법 (또는 최소제곱법)을 적용하여 회귀분석을 하고, 식을 얻을 수 있습니다. (최소자승법은 영어로 Least Squares Method, Least squares,Least squaresapproximation라고 할 수 있습니다.) 최소 제곱법에서 근사해를 구하는 것은 아래의 3가지와 같습니다. 해가 정확히 일치하지는 않지만, 실제값과의 차이가 별로 나지 않는 해를 구하는 것 실제값과 예측값의 오차가 최소화되는 것 실제값과 가장 가까운 예측값을 구하는 것..