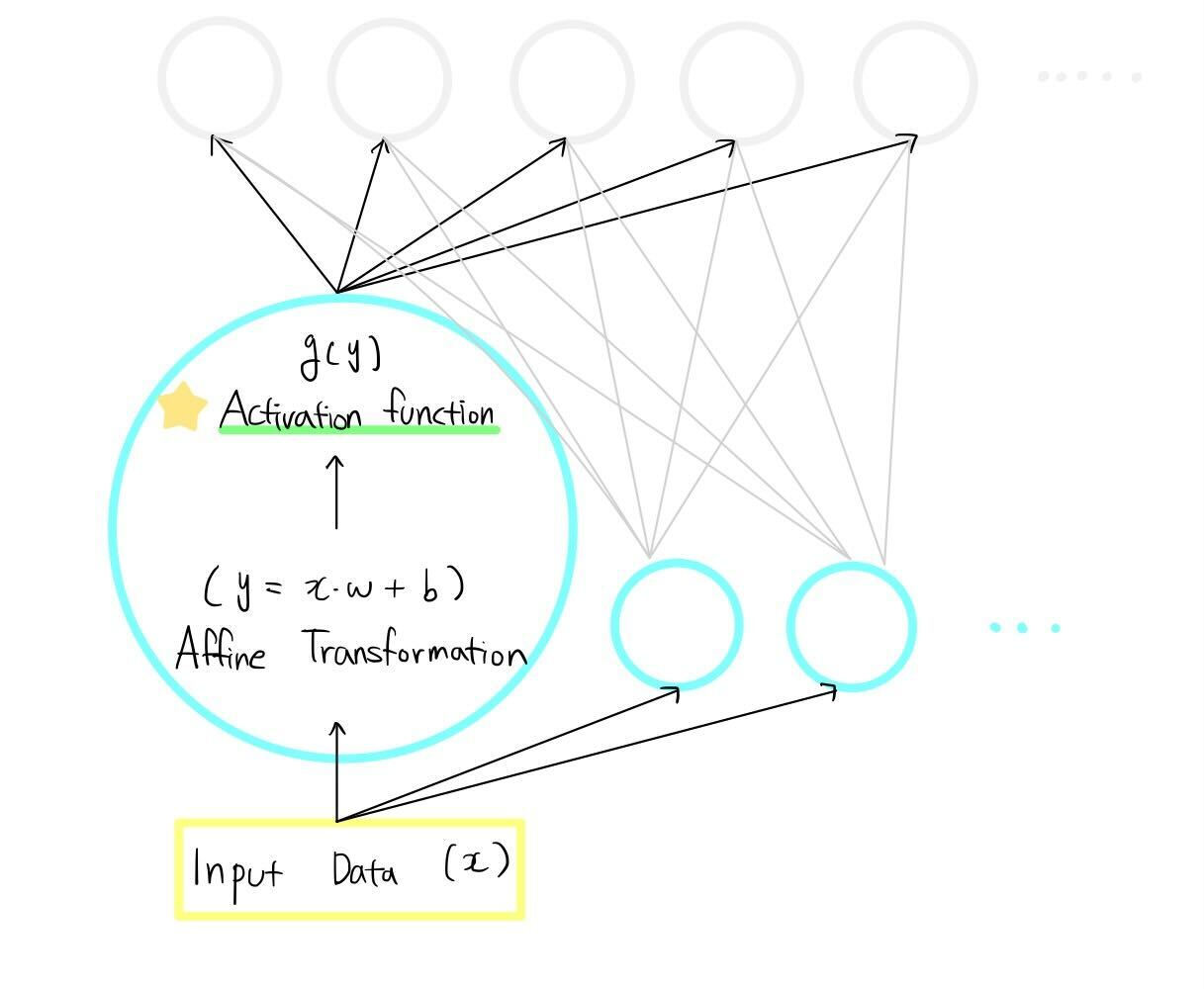

* 공부용으로 자료 조사한 것들을 토대로 정리한 내용입니다. 틀린 내용이 있다면 댓글 부탁드립니다. 활성화 함수란, 비선형 신경망 모델을 만들기 위해 각 뉴런의 Linear Function(Weighted Sum, Affine Transformation,,,)의 결과값에 적용해 주는 함수이다. 하나를 예로 들면, 딥러닝을 위한 신경망 모델(neural networks)의 각 층(Layer)에서 각 뉴런(Neuron)에 Input Data(x)가 입력되면 Affine function(f(x) = z = wx + b), 활성화함수(g(wx + b))를 통해 Output Data가 출력값으로 나온다. g(f(x))라는 합성함수 형태가 하나의 뉴런 안에서 수행되는 연산이다. 이 출력값을 다음 레이어의 입력값으로..